12月2日消息,此前DeepSeek已低调推出DeepSeek V3.2正式版与长思考加强版DeepSeek-V3.2-Speciale,在命名策略上依旧延续了小步迭代的风格。

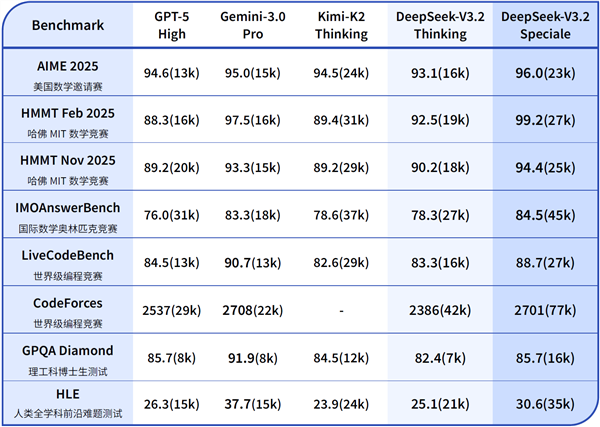

不过DeepSeek V3.2的整体表现相当出色,根据官方介绍,其在推理类Benchmark测试中达到了GPT-5的水平,只是稍稍落后于Gemini-3.0-Pro,并且在IMO国际数学奥林匹克竞赛、中国数学奥林匹克竞赛CMO等多项数学赛事中取得了金牌级别的成绩。

这两天综合各路大V和网友的评测反馈,DeepSeek V3.2相比旧版本进步明显,结合它的定价来看,整体表现确实超出预期。

但也得承认,DeepSeek V3.2这次并未达到当前顶级AI的水准,在编程领域要比肩Claude、Gemini-3.0-Pro还不太现实。

对于当前的情况,DeepSeek官方同样有着清晰的认知。在此次发布的论文里,他们坦言与Gemini-3.0-Pro这类闭源大模型相比存在一定局限性:首先是总训练浮点运算次数(FLOPS)相对较少,这使得模型在世界知识的覆盖广度上不及头部专有模型。对此,团队计划在未来的版本迭代中通过扩大训练规模来缩小这一差距。

其他因素还包括标记效率不及Gemini-3.0-Pro,以及处理复杂任务的能力比不上前沿模型,这些都需要通过改进基础模型和训练后的处理方案来解决。

从DeepSeek的相关表态来看,V3.2版本暴露出的问题,追根究底还是3.X系列的基座大模型已经略显滞后。若要达到当前顶尖AI的水准,就需要投入更多的算力资源与数据支持。

对于这一点,相信DeepSeek是有准备的,V4以及尚未确定是否存在的R2今年始终没有发布,但DeepSeek肯定在为更强大的算力和数据资源做准备了。

按照以往的惯例推测,今年春节前后DeepSeek V4/R2应该就会陆续发布了。